Библиотеки Python для Data Science

3 мин

3 мин

3396

3396  5 Апр 2020

5 Апр 2020

Основатель и Генеральный директор, SF Education

Получите 3-х дневный бесплатный демо-период

Python является одним из самых популярных языков программирования для Data Science и широко используется в этой области. У Python много библиотек и инструментов, специально разработанных для работы с данными, анализа и моделирования.

Библиотеки являются набором предопределенных функций, классов и инструментов, которые облегчают разработку программного обеспечения. Они представляют собой файлы с образцами кода, чтобы каждый раз не набирать его.

Data Science включает в себя несколько этапов и компонентов, которые взаимодействуют между собой:

- Сбор данных: этот этап включает сбор и получение из различных источников, таких как базы данных, файлы, API, датчики и интернет.

- Предобработка данных: на этом этапе они очищаются, преобразуются и подготавливаются для анализа. Это может включать удаление дубликатов, заполнение пропущенных значений, преобразование форматов.

- Анализ: здесь применяются статистические и математические методы для извлечения информации из данных.

- Моделирование и машинное обучение: на этом этапе строятся модели, используя различные алгоритмы.

- Интерпретация и визуализация результатов: результаты анализа и моделирования представляются в понятной форме, чтобы помочь принять решения и сделать выводы. Это может включать визуализацию данных, создание дашбордов.

Data Science широко применяется в различных областях, таких как бизнес, наука, здравоохранение, финансы, маркетинг и многое другое. Она позволяет компаниям и организациям анализировать большие объемы данных, выявлять тенденции, прогнозировать поведение и оптимизировать процессы.

Python и Data Science работают вместе путем использования библиотек и инструментов Python, специально разработанных для обработки, анализа и моделирования информации. Вот пример того, как они могут взаимодействовать: загрузка данных – Python предлагает библиотеки, такие как Pandas, которые позволяют загружать их из различных источников, таких как CSV-файлы, БД, API и другие.

В случае библиотек python для data science, они предоставляют специализированные инструменты и алгоритмы, необходимые для работы с данными, их анализа и визуализации:

- Загрузка и обработка данных: библиотеки, такие как Pandas, позволяют загружать данные из различных форматов, таких как CSV, Excel, SQL, JSON, а также предоставляют функции для чистки, фильтрации, преобразования и агрегации данных.

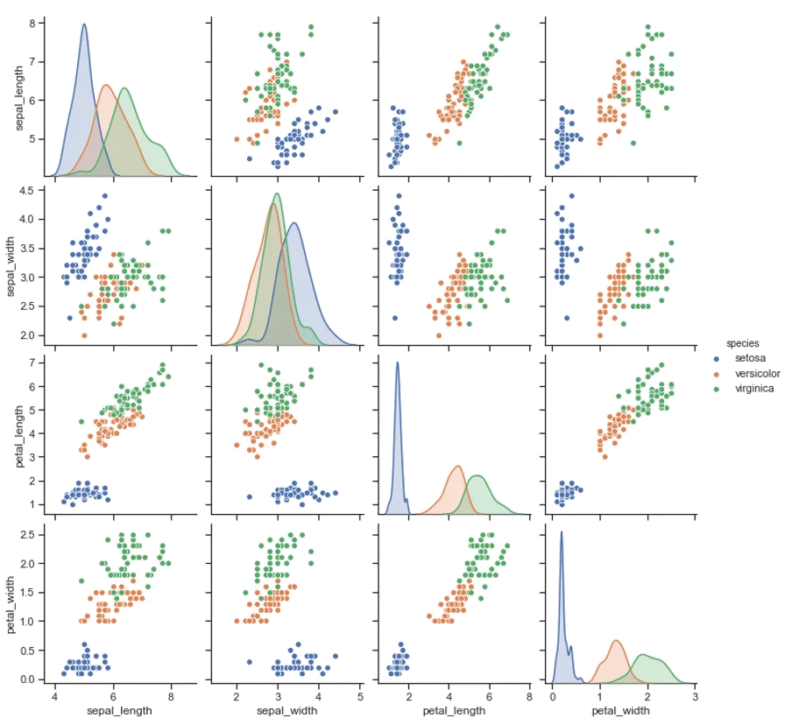

- Визуализация данных: например, Matplotlib и Seaborn, предоставляют инструменты для создания различных типов графиков и диаграмм, которые помогают исследовать данные, выявлять закономерности и представлять результаты анализа.

- Машинное обучение: такие как Scikit-learn, TensorFlow и PyTorch, предоставляют алгоритмы и инструменты для обучения моделей машинного обучения. Они позволяют создавать модели классификации, регрессии, кластеризации, а также решать другие задачи, такие как обработка естественного языка и компьютерное зрение.

- Статистический анализ: одни из базовых библиотек для data science на python, например NumPy и SciPy, предоставляют функции для выполнения статистического анализа данных, включая расчеты основных статистик, тесты гипотез, корреляцию и другие статистические методы.

- Интерактивная разработка и документация: такие как Jupyter Notebook, предоставляют среду для создания и выполнения интерактивных блокнотов, которые объединяют код, текст, графики и другие элементы. Они позволяют разрабатывать аналитические проекты, документировать их и делиться результатами с другими.

Чтобы узнать для чего нужна конкретная библиотека, можно обратиться к ее документации, официальным ресурсам и примерам использования. Вот несколько способов, которые помогут получить информацию о ее функциональности и возможностях:

- Документация: большинство популярных библиотек для data science в python имеют обширную документацию, в которой описывается их функциональность, API, классы и методы. Обычно они содержат примеры кода и подробные объяснения по использованию различных функций. Посетите ее официальный сайт и найдите раздел “Документация” или “Руководство пользователя.”

- Примеры использования: набор примеров использования, которые демонстрируют основные возможности и сценарии применения. Эти примеры могут быть доступны в документации, официальных репозиториях или в блогах и статьях, посвященных конкретной библиотеке. Используйте поисковые системы и сообщества Data Science для поиска таких примеров.

- Онлайн-курсы: существуют различные онлайн-курсы, которые помогут вам изучить использование конкретных библиотек. Эти ресурсы часто включают задачи и примеры, которые помогут вам понять, какие задачи можно решать с ее помощью.

- Сообщества и форумы: присоединитесь к сообществам Data Science, Python таким как форумы, группы в социальных сетях, Slack-каналы и Reddit. Задавайте вопросы, участвуйте в обсуждениях и обращайтесь к экспертам, которые могут поделиться опытом использования.

- Экспериментирование и практика: лучший способ понять, для чего нужна библиотека – это самостоятельное использование и эксперименты с ее функциями. Создавайте небольшие проекты, пробуйте разные функции и методы библиотеки, анализируйте.

Библиотеки Data Science значительно упрощают работу с данными и анализом, позволяя исследователям данных, аналитикам и разработчикам эффективно решать задачи и извлекать ценные инсайты из данных.